Petabayte-Speichersysteme für die Finanzbranche: Storage Nodes im laufenden Betrieb hinzufügen

Fujitsu

Die Datenmengen, die Banken und Finanzdienstleister bearbeiten müssen, steigen drastisch an. Daher benötigen solche Unternehmen leistungsfähige Storage-Infrastrukturen. Doch dabei dürfen die Kosten und der Aufwand für die Administration nicht aus dem Ruder laufen. Ein Plädoyer von Stefan Roth (Fujitsu) für hoch skalierbare Storage-Systeme, die sich bis in den Petabyte-Bereich hinein erweitern lassen.

von Stefan Roth, Fujitsu

Ein Grund der fortschreitenden Digitalisierung in diesem Sektor ist, dass laut einer Studie von Deutsche Bank Research Banken und Finanzdienstleister gezwungen sind ihr Angebot an digitalen Services ausweiten. Das hat vor allem zwei Gründe: der wachsenden Konkurrenzdruck durch die FinTechs und die Erwartungen der Kunden an die Digitalisierungsservices ihrer Finanzdienstleister. So erwarten private und Geschäftskunden heute unter anderem, dass sie alle Finanzgeschäfte online abwickeln und mit dem Smartphone bezahlen können.

FinTechs und Kunden sind die Treiber

Um die Anforderungen von Kunden und Markttrends besser zu verstehen, ist die Finanzbranche auf Big-Data-Analysen angewiesen. Das führt dazu, dass der Bedarf an Speicherplatz in Rechenzentren sowie die Anforderungen an Performance stark zunimmt. Für Finanzdienstleister bedeutet dies, dass sie eine leistungsfähige Storage-Infrastruktur benötigen. Da sich die Kosten aber in Grenzen halten sollen, sind skalierbare Storage-Systeme notwendig. Bei der Auswahl einer geeigneten Lösung möchte ich Ihnen einen Rat geben: Die Lösung sollte die Option bieten, je nach Bedarf Storage Nodes hinzuzufügen. Und das im laufenden Betrieb.

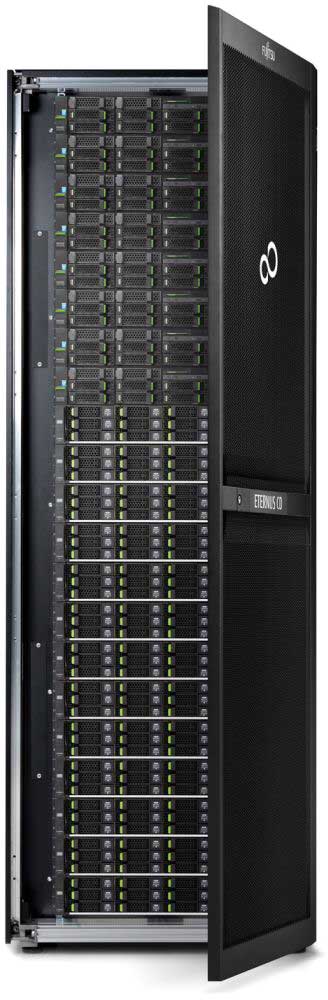

Bild: Fujitsu

Das reduziert die Investitionskosten und gibt der IT-Abteilung die Möglichkeit, einen Teil des Budgets für andere Projekte zu reservieren. Ein Beispiel für ein solches System ist das Hyperscale-Storage-System ETERNUS CD10000 S2 von Fujitsu. Es lässt sich nach Bedarf bis >50 Petabyte erweitern und bietet somit genügend Speicherplatz für Finanzunternehmen mit einem hohen Datenaufkommen, bei gleichzeitig niedrigen Einstiegskosten Ebenso sind Migrationen und damit verbundene Risiken erheblich reduziert bis eliminiert.

Maximale Storage-Kapazität auf engstem Raum

In Datacentern ist physischer Platz Mangelware. Daher sollte ein Storage-System möglichst wenig Fläche beanspruchen. Das lässt sich beispielsweise mithilfe von „Density Nodes” erreichen. Solche Komponenten ermöglichen es, große Datenmengen auf kleinstem Raum zu speichern.

Ein weiteres zentrales Auswahlkriterium für Storage-Systeme sollte ein leistungsfähiges Management der Komponenten und Speicherressourcen sein. Das ist beispielsweise mit der Open-Source-Software Ceph möglich. Sie erlaubt es, ein Cluster von vielen Speicherknoten auf zwei Standorte zu verteilen und zentral zu verwalten. Das erhöht die Ausfallsicherheit der Speicherinfrastruktur. Außerdem ermöglicht es diese Form des Speichermanagements, im laufenden Betrieb ältere Hardware-Komponenten durch neue zu ersetzen. Dadurch kann sich die Lebensdauer der Systeme im Vergleich zu RAID-Systemen um 10 bis 15 Jahre erhöhen.

Fazit

Storage-Systeme, die mehr Leistung und Speicherplatz bieten, zudem eine hohe Skalierbarkeit und Ausfallsicherheit, und das bei akzeptablen Kosten. Das hört sich nach der Quadratur des Kreises an. Entsprechende Hyperscale-Speichersysteme sind bereits verfügbar, mit solchen Lösungen sind Finanzdienstleister und Banken auch für das Petabyte-Zeitalter bestens gerüstet.

Stefan Roth

Sie finden diesen Artikel im Internet auf der Website:

https://itfm.link/24484

Schreiben Sie einen Kommentar