PoC erfolgreich, doch was nun? 4 Erfolgsfaktoren, um KI‑Projekte zum Erfolg zu führen

Adex Partners

von Jan-Erik Bischoff, Senior Manager bei Adex Partners, und Andreas Zitzelsberger, Lead Software Architect und Business Unit Director bei Qaware

PoCs sind ein früher Schritt im Projektlebenszyklus, um Hypothesen zu testen. Ihr Fokus liegt nicht auf Skalierbarkeit oder der Berücksichtigung von Aspekten wie Datenqualität oder Compliance. Stattdessen dienen sie dazu, den Nutzen und die technische Machbarkeit eines Use Cases aufzuzeigen. Dass PoCs scheitern, ist Teil des Innovationsprozesses. Doch warum scheitern selbst viele vielversprechende PoCs, und wie können Sie diese Hürden überwinden? Dieser Artikel beleuchtet die Herausforderungen und zeigt Lösungen für die erfolgreiche Umsetzung von KI-Projekten auf.Der Erfolg eines KI-Vorhabens entscheidet sich in 4 Handlungsfeldern:

1.Strategische Auswahl und Verfeinerung der Use Cases2.Organisatorische Unterstützung und Stakeholder-Buy-In

3.Datenexzellenz

4.Exzellenz in Umsetzung und Betrieb

Daneben ist besonders im Versicherungsbereich Regulatorik und Compliance wichtig. Eine eingehende Betrachtung sprengt aber den Rahmen dieses Artikels.

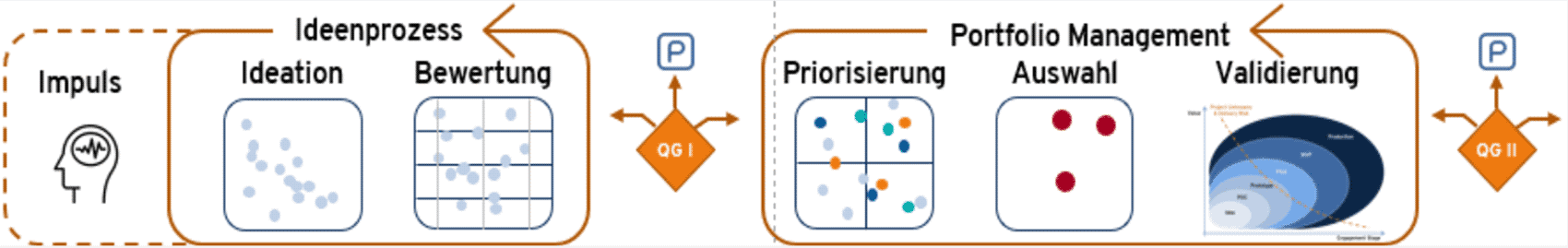

Strategische Auswahl und Verfeinerung der Use Cases

Qaware

Die Wahl der Use Cases ist oft ein entscheidender Erfolgsfaktor. Der Use Case muss klar definiert und für die Nutzer relevant sein, Nutzen und Risiken müssen sauber bewertet werden. Es gilt:

Je offener und flexibler die Anwendung ist und je stärker sie nach außen exponiert ist, desto höher sind das Risiko und der Absicherungsaufwand.”

Daher empfiehlt es sich besonders für die ersten Schritte, weniger offene und weniger nach außen exponierte Use Cases zu wählen. Dabei sollten sowohl die Fachlichkeit als auch Umsetzungs- und Betriebsaspekte berücksichtigt werden. Mit Fortschritt des PoCs sollte eine kontinuierliche Neubewertung durchgeführt werden.

Nicht selten scheitern PoCs, weil die zu lösende Aufgabe entweder nicht klar genug definiert oder zu komplex ist. Ein klarer Fokus ist essenziell.”

Die Bildung von Komponenten und das Teile-und-herrsche-Prinzip sind wichtig, um den Überblick zu behalten, Synergien zu heben und Erfahrungswerte nutzen zu können.

Oft gibt es unerkannte Schnittmengen zwischen scheinbar unabhängigen Use Cases verschiedener Teams. Gemeinsame Komponenten wie Transkriptoren, Voice-to-Text-Module oder Vector Encoder sollten nur einmal, dafür aber in hoher Qualität entwickelt und gewartet werden.

Ein PoC wird häufig als Insellösung mit begrenztem Budget implementiert. Bei Überführung in die Produktion steigen die Kosten jedoch stark an. Hier empfehlen wir, frühzeitig mit soliden Bottom-Up-Schätzungen der Umsetzungs- und Betriebskosten zu beginnen, erst grob und dann mit steigendem Wissen immer präziser. Dies hilft, Budgetzyklen einzuhalten und richtig zu priorisieren.

Die internen Compliance-Funktionen sollten so früh wie möglich in den Prozess einbezogen werden, um Überraschungen zur Unzeit zu vermeiden.

KI birgt besonders das Risiko des Overfitting: Modelle können an Trainingsdaten überangepasst werden und im PoC vielversprechend erscheinen, dann aber an der Realität scheitern.”

Zudem ist es wichtig, die Qualität des Use Cases und Anforderungen und die Passung zu den wirklichen Bedürfnissen der Nutzer kritisch zu hinterfragen. Zu oft wird ein Use Case gewählt, der gut zur Technik passt, aber wenig realen Nutzen stiftet. Ein guter Weg, dieses Ziel zu erreichen, ist frühzeitig Pilot-Nutzer einzubinden.

Organisatorische Unterstützung und Stakeholder-Buy-In

Es liegt in der Natur von PoCs, dass sie oft mit schmalen Mitteln ausgestattet sind. Oft wird ein PoC von einer kleinen Gruppe oder sogar einzelnen Personen eigenständig vorangetrieben.

Sobald der PoC erfolgreich ist und der Use Case in Produktion überführt werden soll, drehen sich die Anforderungen. Nun sind größere Budgets, ein dediziertes Team, klare Verantwortlichkeiten und eine organisatorische Verankerung notwendig. Führungskräfte müssen von der Relevanz überzeugt sein und aktiv unterstützen. Kurz gesagt:

Der Buy-In der Stakeholder und die Sicherstellung der Finanzierung sind entscheidend. “

Dafür ist der Business Case ein zentraler Aspekt. Der potenzielle Mehrwert des Vorhabens muss klar und nachvollziehbar dargestellt werden. Bei innovativen Vorhaben ist es jedoch oft schwierig, den Nutzen seriös zu quantifizieren. Eine gute Möglichkeit ist, Ziele zu definieren und die Erreichung über Metriken bzw. Key Performance Indicators (KPIs) nachvollziehbar zu machen. Das hilft, Chancen und Risiken überzeugend darzustellen und ermöglicht eine Bewertung des Erfolgs.

Neben dem Business Case ist eine solide Roadmap wichtig. Die oben erwähnten Schätzungen sind dafür die Grundlage.

Datenexzellenz

KI-Projekte bringen eine Reihe datenbezogene Herausforderungen mit sich. Schlegel et al. (2022) identifizieren die unzureichende Datenbasis als häufigste Ursache für das Scheitern von KI-Projekten.

Eine der grundlegendsten Herausforderungen liegt in der Bereitstellung und Qualitätssicherung der Daten.”

Für das Training der Modelle werden große Mengen an Daten aus vielen Quellen benötigt. Diese müssen nicht nur an einem zentralen Ort zugänglich gemacht, sondern auch aktualisiert und qualitätsgesichert werden, denn Konsistenz und Vollständigkeit sind von entscheidender Bedeutung.

Mit der Verarbeitung großer Datenmengen gehen auch hohe Anforderungen an den Datenschutz einher. Neben den gesetzlichen Regelungen müssen auch die durch die Datensammlung entstehenden Geschäftsrisiken bewertet und adressiert werden.

Ein unterschätztes Risiko besteht in der Möglichkeit des unbeabsichtigten Datenabflusses bei der Ausführung der Modelle.”

Dies kann besonders bei offenen Anwendungen wie Chatbots eine Herausforderung darstellen. Um diesem Risiko zu begegnen, sind robuste Sicherheitsmaßnahmen, Tests und ein kontinuierliches Monitoring auf verdächtige Aktivitäten unerlässlich.

Die Qualität eines KI-Modells hängt von der Qualität der Trainingsdaten ab. Daher ist es von großer Bedeutung, mögliche Verzerrungen (Bias) in den Daten zu erkennen und zu adressieren. Gleichzeitig muss sichergestellt werden, dass die Trainingsdaten die reale Welt möglichst genau abbilden, um repräsentative und faire Ergebnisse zu erzielen.

KI-Projekte erfordern oft eine erhebliche Skalierung der Dateninfrastruktur. Eine gut durchdachte und skalierbare KI-Infrastruktur ist hier entscheidend für den langfristigen Erfolg des KI-Projekts.

Ein umfassendes Data Governance Framework bildet das Fundament für den nachhaltigen Erfolg von KI-Projekten.”

Es definiert klare Prozesse sowie Rollen und Verantwortlichkeiten für das Datenmanagement. Darüber hinaus ist eine kontinuierliche Überwachung und Verbesserung der Datenqualität wichtig, um die Leistungsfähigkeit und Zuverlässigkeit der KI-Modelle zu gewährleisten.

Exzellenz in Umsetzung und Betrieb

Adex Partners, Qaware

Um einen KI-PoC in die Produktion zu überführen, müssen verschiedene technische Hürden überwunden werden. Die erste Hürde besteht in der Umsetzung:

Im Gegensatz zu einem PoC wird beim Produktivgang zusätzlich zu AI- und ML-Methodenwissen solides und umfassendes Software-Engineering-Know-how wichtig. “

Die zweite Hürde sind Day-2-Operations. Darunter versteht man alle Tätigkeiten, die an einem System durchgeführt werden, nachdem es in einer produktiven Umgebung bereitgestellt wurde. Insbesondere bei leistungsstarken KI-Anwendungen ist die fachliche Überwachung entscheidend: Funktioniert die Anwendung wie erwartet? Wie ist die Qualität der Ergebnisse? Gibt es kritische Ausreißer? Idealerweise stehen hierfür sowohl automatisierte Tests als auch Möglichkeiten zur Verfügung, die es Experten erlauben, Einblick in die Abläufe und Entscheidungen der Anwendung zu erhalten.

Manuelle Testaufwände gilt es zu vermeiden, denn diese senken die Performance der Entwicklung und die Qualität und erhöhen die Kosten. Durch ihre nicht deterministische Natur gestaltet sich die Qualitätssicherung bei KI-Anwendungen komplexer als bei anderen Anwendungen. Ergebnisse können nicht direkt miteinander verglichen werden, sondern müssen anhand verschiedener Kriterien wie Korrektheit, Kontextbezug, Referenzgenauigkeit, faktische Kohärenz, Schädlichkeit, Halluzinationen und Sprachverwendung interpretiert und bewertet werden.

Für GenAI-Anwendungen empfiehlt es sich, eine GenAI-Testbench zu schaffen, die skalierbare und automatisierte Absicherung ermöglicht, indem sie moderne Ansätze wie „LLM-as-a-judge“ einsetzt.”

Sie ermöglicht Fachexperten eine unkomplizierte Erstellung von Testfällen. Durch die automatisierte Durchführung sowie die Erfassung und Visualisierung relevanter Kennzahlen wird eine fundierte Bewertung der Ergebnisqualität sichergestellt.

Jan-Erik Bischoff ist Senior Manager bei Adex Partners (Website) in Hamburg mit umfassender Erfahrung in Business Model Transformation, Future of Work und Generative AI. Seine beruflichen Stationen umfassen über drei Jahre bei Adex Partners und mehr als fünf Jahre bei EY, wo er sich auf Power Platform, Cloud-Projekte und Service Level Management spezialisiert hat. Er ist zertifiziert in Microsoft Azure und ITIL und bringt tiefgehende Kenntnisse in der Umsetzung agiler Methoden und RPA-Lösungen mit. Zusätzlich hat er Erfahrung in der Analyse und Visualisierung komplexer Daten für IT-Transformationsprojekte.

Jan-Erik Bischoff ist Senior Manager bei Adex Partners (Website) in Hamburg mit umfassender Erfahrung in Business Model Transformation, Future of Work und Generative AI. Seine beruflichen Stationen umfassen über drei Jahre bei Adex Partners und mehr als fünf Jahre bei EY, wo er sich auf Power Platform, Cloud-Projekte und Service Level Management spezialisiert hat. Er ist zertifiziert in Microsoft Azure und ITIL und bringt tiefgehende Kenntnisse in der Umsetzung agiler Methoden und RPA-Lösungen mit. Zusätzlich hat er Erfahrung in der Analyse und Visualisierung komplexer Daten für IT-Transformationsprojekte.

Andreas Zitzelsbergerist Lead Software Architect und Business Unit Director bei QAware (Website) in München. Seine Kernkompetenzen liegen in den Bereichen Cloud, Cloud-Native-Sicherheit und Anwendungsmodernisierung. Mit über 14 Jahren Erfahrung bei QAaware hat er als Entwickler, Architekt und Bereichsleiter zahlreiche Projekte erfolgreich umgesetzt. Zudem bringt er umfangreiche Erfahrung als freiberuflicher Webentwickler und aus früheren Tätigkeiten in verschiedenen Software- und IT-Positionen mit.

Andreas Zitzelsbergerist Lead Software Architect und Business Unit Director bei QAware (Website) in München. Seine Kernkompetenzen liegen in den Bereichen Cloud, Cloud-Native-Sicherheit und Anwendungsmodernisierung. Mit über 14 Jahren Erfahrung bei QAaware hat er als Entwickler, Architekt und Bereichsleiter zahlreiche Projekte erfolgreich umgesetzt. Zudem bringt er umfangreiche Erfahrung als freiberuflicher Webentwickler und aus früheren Tätigkeiten in verschiedenen Software- und IT-Positionen mit.

Weiter muss die Infrastruktur betrachtet werden. Sollen Software-as-a-Service (SaaS)-Services genutzt oder eigene Cloud- bzw. On-Premise-Infrastrukturen eingesetzt werden? Ist spezielle Hardware erforderlich, oder kann der Use Case auf günstiger Standard-Hardware laufen? Können die KI-Angebote eines Hyperscalers wie AWS oder Azure genutzt werden?

Eine besonders spannende Möglichkeit für KI ist die Nutzung von Edge Computing auf den Endgeräten der Nutzer.”

Aus Nutzersicht ist der wesentliche Vorteil die bessere User Experience, aus Sicht des Betreibers ist vor allem die Nutzung der Endgeräte-Hardware anstatt zentraler Infrastruktur aus Kosten- und Datenschutzsicht attraktiv.

Das Thema Skalierung des Use Cases ist eng mit der Frage der Infrastruktur verwoben. Es stellen sich mehrere Fragen:

1.Welche Ressourcen und welche Infrastruktur sind notwendig, um den Use Case produktiv zu betreiben?2.Welche Kosten verursachen SaaS-Dienste bei Skalierung?

3.Funktioniert der PoC auch, wenn er für viele Nutzer zugänglich gemacht wird, oder ist ein Re-Design erforderlich?

Um fundierte Entscheidungen treffen zu können, sind aussagekräftige Testszenarien sowie automatische Last- und Stresstests essenziell.

Eine KI-Plattform hilft, Regulatorik und Compliance, technische Hürden und Herausforderungen in der Delivery zu meistern und ist auch bei der Überwindung von organisatorischen Hürden hilfreich.”

Diese schafft systematisch eine solide technische Grundlage für das gesamte KI-Projekt. Eine solche Plattform kann entweder im eigenen Rechenzentrum mithilfe von Open-Source-Lösungen oder in der Cloud mit Bausteinen von Drittanbietern aufgebaut werden. Wir empfehlen einen Best-of-Breed-Ansatz mit ausgiebiger Nutzung produkthafter Komponenten, ergänzt um individuelle Anteile.

Die Plattform löst Teile der Compliance-Anforderungen direkt in der Plattform, etwa durch sichere Datenhaltung, querschnittliche Bereitstellung von Datenpflege-Prozessen oder Umsetzung von Desaster-Recovery-Fähigkeit direkt in der Plattform. Sie sollte zusätzlich mit Leitplanken versehen sein, die Anwendungen auf der Plattform einen Rahmen für sicheren und compliant Betrieb geben, sowie Automatismen, die Einhaltungen der Leitlinien zu steuern.

Die Plattform bindet zentrale Datenquellen in der Organisation sicher und einheitlich an und bietet Primitiven, die die Anbindung weiterer Datenquellen erleichtert.”

Die Plattform sollte dabei so konzipiert werden, dass sie mehrere Modelle unterstützt, wodurch unternehmensweite Synergieeffekte erzielt werden können.

Eine gut konzipierte Plattform erleichtert die Skalierung der KI-Projekte, reduziert die kognitive Komplexität für die KI-Anwendungsprojekte und reduziert den Abstimmungsaufwand zwischen den verschiedenen Stakeholdern und Berufsgruppen wie Fachbereich und IT, Data Scientists, Data Engineers und Plattform Engineers. Die Plattform erzeugt so Vertrauen und hilft damit, Stakeholder zu überzeugen und organisatorische Hürden zu überwinden.

Zusammenfassung & Fazit

Die Einführung generativer KI in der Versicherungsbranche verspricht mehr Effizienz und neue, innovative Dienstleistungen.

Der Übergang vom PoC zur Produktion ist jedoch von Herausforderungen geprägt – darunter technische Hürden, Datenmanagement, organisatorische Komplexität und regulatorische Vorgaben.”

Ein realistischer Blick und systematisches Vorgehen sind hier entscheidend.

Ein frühes und kontinuierliches Assessment, das technische, organisatorische und regulatorische Aspekte berücksichtigt, bildet die Basis für eine erfolgreiche Umsetzung. KPIs ermöglichen eine transparente Bewertung des Projekterfolgs. Zudem ist eine enge Abstimmung zwischen Stakeholdern essenziell, um Synergien zu nutzen und Konflikte frühzeitig zu erkennen.

Durch die gezielte Berücksichtigung dieser Faktoren können Unternehmen die Vorteile von KI voll auszuschöpfen um im wettbewerbsintensiven Markt zu bestehen.Jan-Erik Bischoff, Adex Partners, und Andreas Zitzelsberger, Qaware

Sie finden diesen Artikel im Internet auf der Website:

https://itfm.link/218497

Schreiben Sie einen Kommentar