Explainable AI für Versicherer: XAI schafft Transparenz beim Einsatz von Künstlicher Intelligenz

adesso

Automatisierte Leistungsbearbeitung und Auszahlung im Schadensfall, Annahme oder Ablehnung nach einer Risikoprüfung, maßgeschneiderte Angebote und Produktplatzierungen in jeder Lebenslage – die Liste an Potenzialen von Künstlicher Intelligenz (KI) in der Versicherungsbranche ist lang und eröffnet Versicherern zahlreiche Anwendungsmöglichkeiten. Die größte Hürde ist jedoch die Intransparenz bei der Entscheidungsfindung durch eine KI. Die Regulatorik macht deutlich: Blackbox-Anwendungen werden in aufsichtspflichtigen Modellen nicht akzeptiert. Es muss für alle Akteure nachvollziehbar sein, wie diese Algorithmen zu einer Entscheidung kommen, denn nur so kann das notwendige Vertrauen sowohl für den Versicherten aber auch besonders in unternehmensrelevanten Fragestellungen aufgebaut werden.

von Jan Jungnitsch und Ann-Kathrin Bendig, adesso

adesso

Erklärbarkeit, Nachvollziehbarkeit und Transparenz in den Fragestellungen, wieso, weshalb und warum bestimmte Entscheidungen getroffen werden – egal ob durch den Menschen oder eine KI –, hat in der Versicherungsbranche also oberste Priorität.”

Mit Explainable AI Licht ins Dunkel bringen

Explainable AI (XAI) schafft eine Umwandlung der „Blackbox“ in eine „Whitebox“ und trägt somit maßgeblich zur geforderten Transparenz, Erklärbarkeit und Nachvollziehbarkeit von Entscheidungen der KI bei.

Die Erklärbarkeit als solches befasst sich mit der Frage, warum die XAI beziehungsweise das Modell eine bestimmte Entscheidung generiert hat. Wurde ein Versicherungsinteressent beispielsweise nach Antragseingang in der Lebensversicherung abgelehnt, muss der Versicherer erklären können, wieso es zu einer Ablehnung der Risikoübernahme kam. Diese Entscheidung muss frei von jeglicher Diskriminierung sein. Um den Prozess und die generierte Entscheidung zu verstehen, muss eine vollständige Rückverfolgbarkeit gewährleistet sein. Gerade auf Unternehmerseite spielt hier das Vertrauen in die Entscheidung beziehungsweise das Modell eine enorme Rolle, da hinter jeder Annahme ein kalkuliertes versicherungstechnisches Risiko steht.

Mit Hilfe der Transparenz kann der Entscheidungsprozess zugänglich gemacht werden. Die Transparenz bezieht sich dabei sowohl auf die Datenherkunft als auch auf die Algorithmen respektive den Weg bis hin zur Entscheidungsfindung.

Die Nachvollziehbarkeit von mathematischen Modellen und Entscheidungswegen für die unterschiedlichen Nutzergruppen stellt sicherlich eine der größten Herausforderungen dar. Müssen doch hier die Informationen so aufbereitet sein, dass sie für den jeweiligen Nutzer verständlich sind. Mathematische Beschreibungen von Modellen stellen für den Data Scientist sicher kein Problem dar, diese sind ja schließlich sein Handwerkszeug. Für den Fachanwender hingegen muss die Information anders aufbereitet sein, um das geforderte Kriterium der Nachvollziehbarkeit zu erfüllen.

Beim Einsatz von XAI muss eine Balance zwischen Erklärbarkeit, Transparenz und Nachvollziehbarkeit gefunden werden, die den Interessen aller Akteuren sowie der jeweiligen Anwendungsdomäne entspricht.”

Ansätze der XAI

Jan Jungnitsch ist Competence-Center-Leiter im adesso-Geschäftsbereich (Webseite) für Versicherungen. In verschiedenen Projekten bringt er seine Erfahrung als Projektleiter und Requirements Engineer in cloudbasierten Projekten ein. Darüber hinaus unterstützt er Vertriebsprozesse zu Digitalisierungsthemen.

Jan Jungnitsch ist Competence-Center-Leiter im adesso-Geschäftsbereich (Webseite) für Versicherungen. In verschiedenen Projekten bringt er seine Erfahrung als Projektleiter und Requirements Engineer in cloudbasierten Projekten ein. Darüber hinaus unterstützt er Vertriebsprozesse zu Digitalisierungsthemen.

Ann-Kathrin Bendig ist Senior Consultant im adesso-Geschäftsbereich (Webseite) für Versicherungen. Sie ist seit neun Jahren in der Versicherungsbranche aktiv und verfügt über ausgeprägte Kenntnisse interner Prozesse. Als Requirements Engineer, Analyst, Softwaretesterin und Projektleiterin betreut sie Projekte, die die Schnittstelle zum Endkunden abbilden.

Aus technischer Sicht können in der XAI verschiedene Ansätze verfolgt oder kombiniert werden. Mathematische Sichtweisen auf die Datensätze finden in explorativen Ansätzen, sogenannte Ante-Hoc-Verfahren Anwendung. Mit Hilfe von Kennzahlen wie Varianzen und Mittelwerten lassen sich Datensätze erklären und dokumentieren.

Dem gegenüber stehen Design-Ansätze, die die Entwicklung von anschaulichen und leicht verständlichen Modellen fokussieren. Hier liegt der Spagat zwischen steigender Verständlichkeit und dem Verlust von relevanten Informationen.”

Post-Hoc-Ansätze ermöglichen es dem Anwender, sich im Modell zu orientieren und beispielsweise ein neuronales Netz rückwärts von der Ausgabe (Output Layer) durch den verborgenen Teil (Hidden Layer) sich zur Eingabe (Input-Layer) an den Neuronen zu bewegen und somit festzustellen, welche Eingabe schließlich zu welchem Ausgabeergebnis geführt hat. Hierdurch wird gerade die Möglichkeit geschaffen, ein Modell und deren Trainingsergebnisse zu beurteilen.

Ein weiterer Schritt, der die Erklärungen eines Modells und die Verständlichkeit verbessert, wird durch die Nutzung eines hybriden Ansatzes erreicht. Hierbei wird das tatsächliche Modell exploriert und durch Approximation an den Entscheidungsgrenzen ein vereinfachtes Ersatzmodell erzeugt. Dies ist in seiner Simulation einfacher zu verstehen und performanter. Dies funktioniert allerdings nur bei Verwendung von nachvollziehbaren Trainingsdaten.

Nutzergruppen als neue Herausforderung

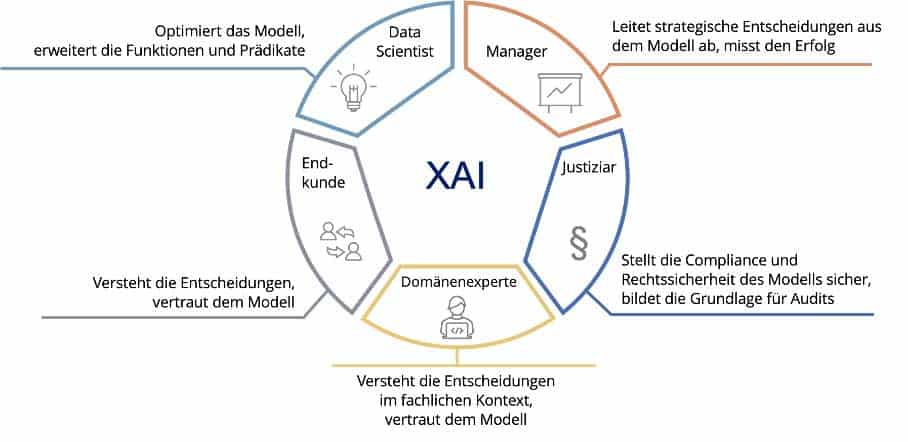

Eine neue Herausforderung bei XAI stellen die Nutzer des Modells dar. Der gemeinsame Nenner der verschiedenen Zielgruppen ist die Gewinnung von möglichst vielen Informationen. Aus ihrer Rolle heraus hat jeder Akteur jedoch unterschiedliche Anforderungen an die oben beschriebenen Dimensionen der Erklärung über das gleiche Modell. Erklärungsmodelle müssen daher für alle Beteiligten zugänglich und verständlich sein, sodass jede Zielgruppe ihre individuellen Zwecke kontextbezogen aus dem Modell generieren kann.

adesso SE

Das grundsätzliche Problem bei Modellen ist, dass die Entscheidungspfade an sich intransparent sind. Dem Data Scientist geht es in erster Linie darum, das Modell in der Basis zu erfassen, zu verstehen, wie es funktioniert und beispielsweise das Debugging des Modells durchführen zu können. Manager erwarten Ergebnisse auf einer strategischen Abstraktionsebene, in etwa indem es ähnlich eines Dashboards funktioniert, sodass die Ergebnisse und nicht die Entscheidungspfade erkennbar sind (zum Beispiel precision, measures to success). Die regulatorische Entität will Aussagen darüber haben, mit welcher Genauigkeit Entscheidungen getroffen wurden, ob sie rechtskonform sind, ob sie gegebenenfalls gegen ethische Grundsätze verstoßen (zum Beispiel Ablehnung einer Police aufgrund der Herkunft) und ob sie schließlich transparent sind, sodass sie der juristischen Prüfung und der Revisionssicherheit standhalten. Hierunter fällt auch die revisionssichere Speicherung der Entscheidungen (Post-hoc). Domänenexperten brauchen ähnlich wie der Endkunde Entscheidungen auf einer sprachlich klar formulierten Ebene und auf einem abstrahierten Modell, wie Entscheidungsbäume oder andere grafische Darstellungen (beispielsweise BI-Dashboards, Cluster).

Chancen durch Explainable AI

Die Neugier und Aufgeschlossenheit gegenüber Künstlicher Intelligenz wächst weiter. Der Einsatz beschränkt sich derzeit noch auf vereinzelte Geschäftsfälle. XAI kann durch ihre Offenheit den Weg für Künstliche Intelligenz in der Versicherungsbranche ebnen, da nur durch die Erklärbarkeit der geforderte Anspruch an Transparenz und der versicherungsspezifische Grundgedanke – sowohl auf Versicherungsnehmer-, als auch auf Unternehmensseite – von Vertrauen, Schutz und Sicherheit erfüllt werden können.

XAI legt neue Zusammenhänge offen, die vorher nicht erkennbar waren.”

Hier entsteht eine Form der Interaktion zwischen Nutzer und Modell der KI. Der Mensch ist nicht nur der Ausgabeempfänger der Entscheidung, sondern wird als Anwender näher an die KI und deren „Denkprozesse“ geführt. Mit dem Einsatz von XAI wird eine andere, neue Herangehensweise gefordert, da tiefgreifend und umfangreicher an die Ebene der Abstraktion und Erläuterung herangegangen werden muss.

Ansätze der XAI lassen sich kombinieren, wobei das Zusammenspiel von Komplexität der Entscheidung und Einfachheit der Erklärung abgewogen werden muss.”

Um neue Ansätze im gesamten Betrieb zu etablieren, ist ein tiefgreifender Change-Prozess innerhalb der Organisation notwendig, der sowohl neue Technologien, Prozesse, Rahmenbedingungen als auch das Mindset der Akteure umfasst. An einigen Stellen innerhalb der Organisation trifft man mit Sicherheit auf Anwendungsfälle, bei welchen keine Erklärbarkeit gefordert wird, sondern vielmehr die Leistung maximiert wird. Hier gilt es abzuwägen, welche Form des Maschinellen Lernens sinnhaft ist. Gerade bei solchen Bereichen die das Leben des Menschen unmittelbar betreffen ist XAI unabdingbar.Jan Jungnitsch und Ann-Kathrin Bendig, adesso

Sie finden diesen Artikel im Internet auf der Website:

https://itfm.link/133530

Schreiben Sie einen Kommentar