Schatten-KI stoppen: So nutzen Unternehmen generative KI sicher und effektiv

Mindbreeze

von Jakob Praher, CTO Mindbreeze

Die Suche nach Informationen und die Interaktion mit Dokumenten in der täglichen Arbeit nimmt oft sehr viel Zeit in Anspruch – vor allem, weil trotz umfassender Daten stets eine hohe Detailtreue gewährleistet sein muss. Künstliche Intelligenz ist mittlerweile in der Lage, Angestellte bei diesen Aufgaben gut zu entlasten.Die einfache Verfügbarkeit von KI-Tools wie etwa ChatGPT oder DeepL, die direkt über den Browser genutzt werden, wirft dabei kritische Fragen auf:

Was geschieht mit den eingegebenen Daten, und wie werden diese verarbeitet oder werden sie möglicherweise an Dritte weitergegeben?”

Auch neue KI-Funktionen von lizenzierten Cloud-Produkten bergen ähnliche Risiken, insbesondere wenn unklar bleibt – wie es oft der Fall ist –, wo Anbieter genau die Daten speichern und wer sich darauf Zugriff verschaffen könnte.

Unternehmen sind daher gut beraten, so schnell wie möglich ihren Mitarbeitenden jene Tools Datenschutz- und Compliance-konform zur Verfügung zu stellen, die sie ohnehin einfach über das Internet nutzen könnten.”

Neben der Einhaltung von strengen Datenschutzbestimmungen ist es auch wichtig, Halluzinationen von generativer KI zu vermeiden. Denn so toll die Antworten von ChatGPT und Co. auch klingen, inhaltlich korrekt sind diese nicht immer.

Large Language Models und Halluzinationen

Large Language Models (LLMs), die KI-Technologie hinter ChatGPT, erkennen zwar Muster in Texten, können aber keine tatsächliche inhaltliche Prüfung vornehmen oder tiefere Verständnislogik für Aussagen entwickeln. Sie verarbeiten die Informationen, mit denen sie trainiert wurden, lediglich auf Basis von Wahrscheinlichkeiten und statistischen Zusammenhängen.

Wenn LLMs keine eindeutige Information finden oder widersprüchliche Daten vorliegen, kann es durch die Wahrscheinlichkeitsberechnungen zu fehlerhaften Schlüssen kommen.”

Das spiegelt sich in veralteten oder falschen generierten Inhalten wider, die aber plausibel klingen und so zu Fehlentscheidungen verleiten können.

Genau hier setzt „Retrieval Augmented Generation“ (RAG) an, eine Technik, die nicht nur Halluzinationen minimiert, sondern auch generative KI in einer sicheren, abgeschlossenen Umgebung ermöglicht.”

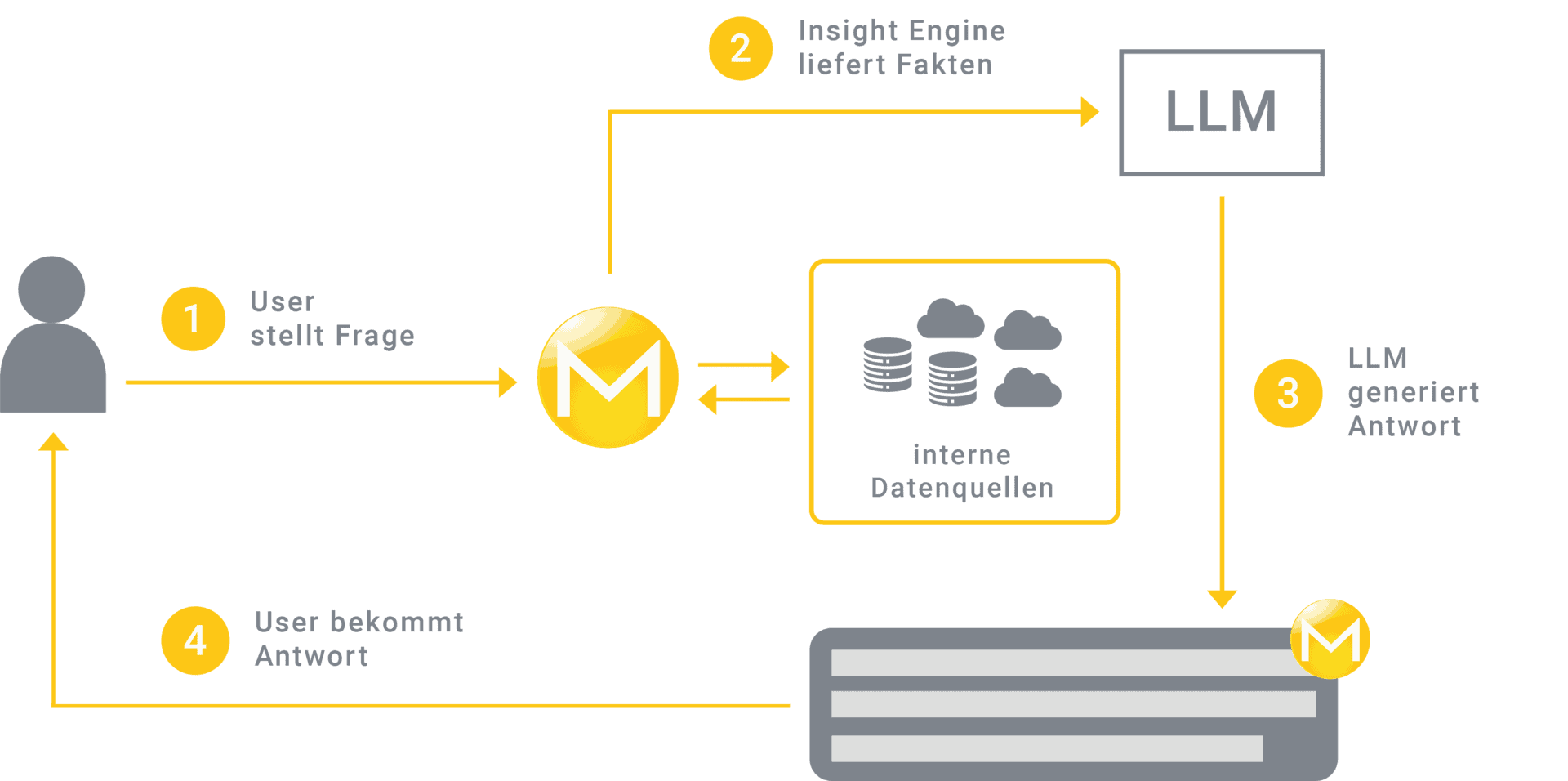

Retrieval Augmented Generation mit Insight Engine als sichere Lösung

RAG erlaubt es Unternehmen, Large Language Models (LLMs) gezielt mit ihren eigenen Datenquellen zu verknüpfen. Anders als ChatGPT, das normalerweise auf Basis seiner Trainingsdaten antwortet, nutzt der RAG-Ansatz mit einer Insight Engine insbesondere unternehmensinterne Informationen.

Die sogenannte Insight Engine übernimmt dabei die Aufgabe, relevante Informationen aus internen Quellen rechtegeprüft zu liefern und samt Quellenangaben an ein intern gehostetes LLM, wie zum Beispiel Llama 3.1 von Meta, weiterzuleiten.”

Auf dieser Grundlage erstellt das LLM präzise Antworten in natürlicher Sprache, die klar formuliert und durch die entsprechenden Quellen untermauert sind.

Mindbreeze

Retrieval Augmented Generation in der Praxis

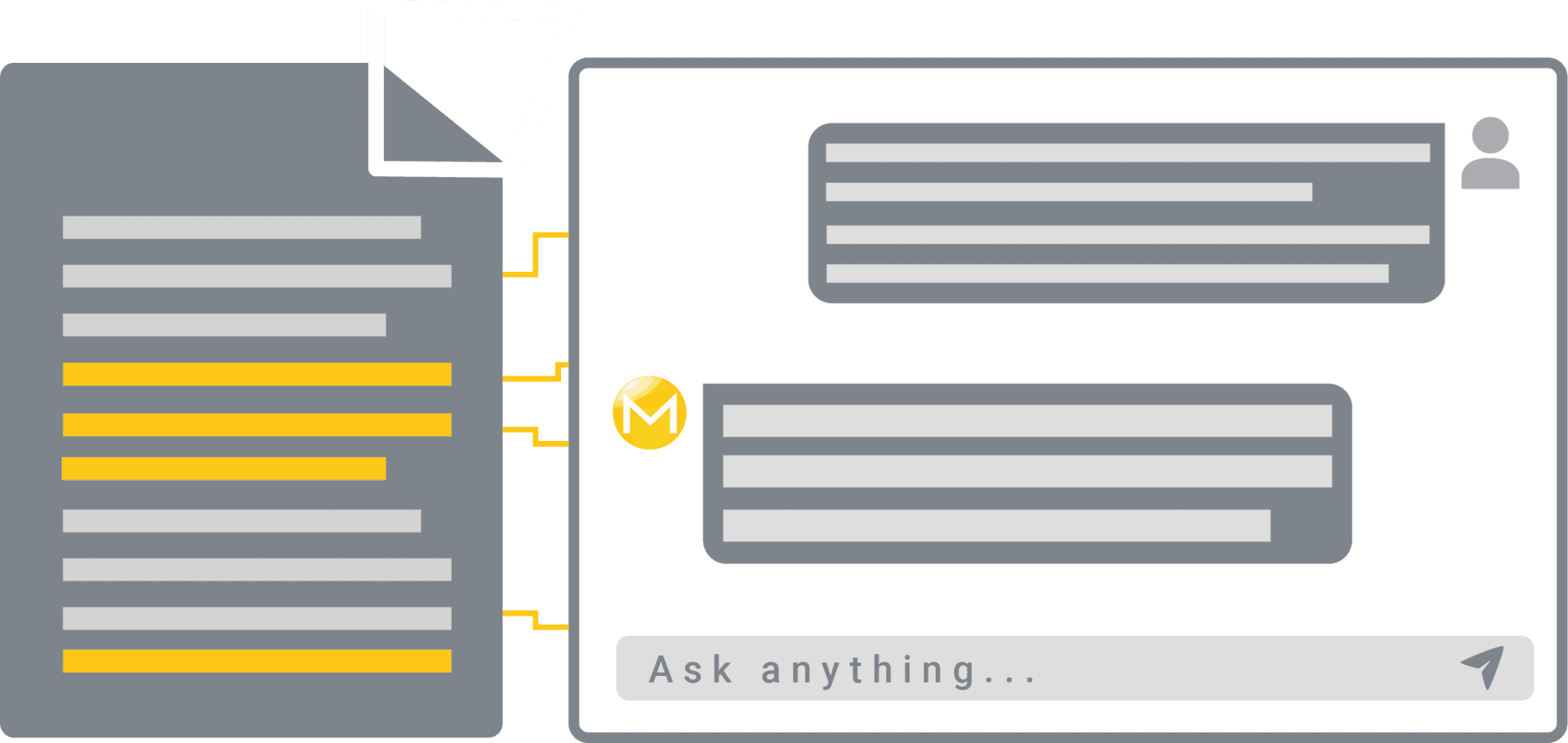

Eine Kundin fragt beispielsweise, welche Schritte sie unternehmen muss, um ihre Hypothek vorzeitig abzulösen. Anstatt mehrere Seiten mühselig durchzuarbeiten, stellt der Bankangestellte einfach eine Frage in natürlicher Sprache an einen internen Chatbot.

Die Insight Engine identifiziert die relevanten Kundendokumente, mit denen der Angestellte direkt chattet.”

Bei einer spezifischen Anfrage extrahiert die Insight Engine die wichtigsten Informationen und übermittelt sie an das LLM, das daraus eine präzise Antwort formuliert. Der Angestellte erhält zusätzlich farblich hervorgehobene Textstellen im Dokument, um die Aussagen bei Bedarf schnell zu überprüfen. Dies optimiert die Arbeit mit umfangreichen, komplexen Dokumenten und ermöglicht es dem Kundenservice, zügig auf anspruchsvolle Anfragen zu reagieren. Das zeitintensive Suchen und Zusammenstellen von Informationen entfällt, und vorformulierte Antworten sparen wertvolle Zeit.

Mindbreeze

Jakob Praher ist CTO bei Mindbreeze (Website), einem Anbieter von KI-basierten Wissensmanagementlösungen mit Standorten in Europa und Nordamerika. Seit jeher ist er fasziniert von der Expressivität und Effektivität mathematischer Methoden und deren skalierbare algorithmische Umsetzungen in effiziente Lösungen.

Jakob Praher ist CTO bei Mindbreeze (Website), einem Anbieter von KI-basierten Wissensmanagementlösungen mit Standorten in Europa und Nordamerika. Seit jeher ist er fasziniert von der Expressivität und Effektivität mathematischer Methoden und deren skalierbare algorithmische Umsetzungen in effiziente Lösungen.Höchste Flexibilität und Sicherheit bei der Datenanbindung und -speicherung.

Dabei ist egal, wo die relevanten Daten liegen, ob auf internen Servern, in internen Cloudsystemen oder auf gängigen Marketplaces wie Microsoft Azure, Google Marketplace, Oracle oder Amazon AWS.”

Besonders attraktiv ist die Kombination von Insight Engine und LLM aber für jene Unternehmen, die aufgrund sehr hoher Sicherheitsbestimmungen ihre Daten auf internen Servern und selbst gehosteten Cloudsystemen verwalten. Denn durch den Retrieval-Prozess der Insight Engine bleiben die Daten stets an ihrem ursprünglichen Speicherort, werden nicht zwischengespeichert oder an Drittanbieter weitergegeben.

RAG als vertrauenswürdige KI-Methode für Unternehmen

Zusammenfassend lässt sich sagen, dass Unternehmen auf interne Lösungen wie Retrieval Augmented Generation setzen sollen, um Schatten-KI abzuwenden und die Risiken der Nutzung von generativer KI zu minimieren. Durch die Kombination von LLMs und Insight Engines werden Antworten ausschließlich aus den eigenen, sicheren Datenquellen generiert.

Jakob Praher, MindbreezeDer Business-Value liegt auf der Hand: Effizientere Prozesse, schnellerer Zugriff auf präzise Informationen, eine signifikante Entlastung der Mitarbeitenden und eine daraus resultierende höhere Kundenzufriedenheit.”

Sie finden diesen Artikel im Internet auf der Website:

https://itfm.link/219974

Schreiben Sie einen Kommentar