FS-Demo: CVA-Risikomanagement über 300 Container-Instanzen auf der Google-Cloud

bigstock.com

Hazelcast (Anbieter Cloud-Anwendungsplattform) veröffentlicht heute eine Referenzimplementierung für Finanzdienstleister. Finanzielle Risikoberechnungen in der Cloud würden damit einfacher werden und künftig auch die Skalierung mit Echtzeit-Performance umfassen.

Das finanzielle Maß für das Risiko einer Geschäftsserie im Falle, dass die Gegenpartei ihren Verpflichtungen nicht nachkommt, ist Credit Value Adjustment (CVA). Deren Berechnungen sind typischerweise umfangreiche Rechenaufgaben. Durch die Möglichkeit der Skalierung auf Anforderung sollen Finanzdienstleister ihre Berechnungskosten über die Hazelcast-Lösung (Website) nun besser kontrollieren können, indem sie nur für die genutzten Ressourcen zahlen. Mit der jetzt vorgestellten Referenzarchitektur könne die In-Memory-Computing-Plattform die Vorteile von Cloud-Umgebungen nutzen, vor allem wenn es um Elastizität und Agilität ginge. Für Anwendungsfälle, in denen Latenz, Vorhersagbarkeit und Skalierbarkeit entscheidend sind, kann die Finanzdienstleistungsbranche jetzt unternehmenskritische Anwendungen in die Cloud migrieren und durch die Nutzung ultraschneller In-Memory-Technologien einen Wettbewerbsvorteil generieren.Weg von der Stapelverarbeitung – hin zum Stream

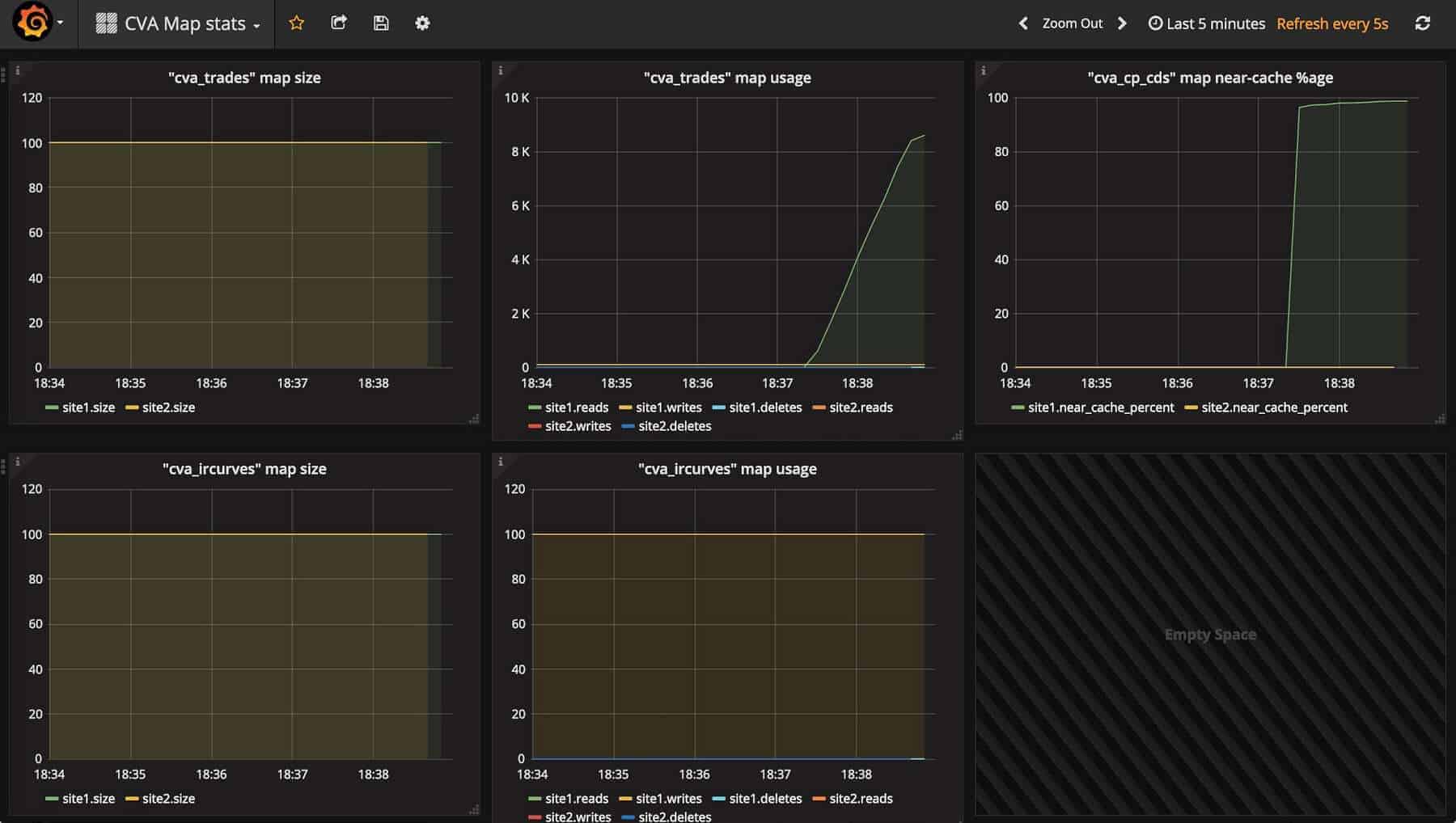

Sobald In-Memory-Technologien implementiert sind, lassen sich die Daten eines oder mehrerer Geschäfte aus einer Datenbank laden und über eine Caching-Schicht mit mehreren Knoten verteilen.

Hazelcast

Diese dienen dann als Eingabewerte für ein Netzwerk von Berechnungsinstanzen, welche die zugeteilten Berechnungsblöcke parallel ausführen. Die Ergebnisse wandern wieder zurück in die Caching-Schicht. In diesem Szenario ist oft eine große Rechner-Farm mit etwa 40.000 CPU-Kernen nötig, um die massive Anzahl an Berechnungen in minimaler Zeit abzuschließen.

Hazelcast

Die wirtschaftlichen Vorteile der Cloud sind bekannt, vor allem die Möglichkeit, dabei nur für die in Anspruch genommenen Ressourcen zu zahlen. Implementierungen im eigenen Rechenzentrum, die nur für bestimmte Workloads bestimmt sind, nutzen die verfügbaren Ressourcen nicht zu 100%. Die Investition in die Infrastruktur zahlt sich damit nicht voll aus. Für Anwendungsfälle, in denen Latenz, Vorhersagbarkeit und Skalierbarkeit entscheidend sind, wie in diesem Szenario des Risikomanagements, bietet Hazelcast der Finanzdienstleistungsbranche eine Blaupause für die Migration unternehmenskritischer Anwendungen in die Cloud und die Nutzung ultraschneller In-Memory-Technologien, um einen Wettbewerbsvorteil zu erzielen.”

John DesJardins, Chief Technology Officer Hazelcast

Hazelcast

Der verteilte Hazelcast-Datenspeicher mit datengesteuerter Stream-Verarbeitung ersetzt in diesem Modell die Stapelverarbeitung durch eine Art Pipelinesystem. Es schiebt die Eingabedaten in die Berechnungsfarm, orchestriert effizient die Berechnungen und sammelt dann die Ergebnisse ein, sobald sie vorliegen. Dieser sogenannte “Straight-Through”-Verarbeitungsansatz eliminiert das Zwischenspeichern von Daten in jeder Berechnungsphase und beschleunigt den Gesamtprozess.

Hazelcast

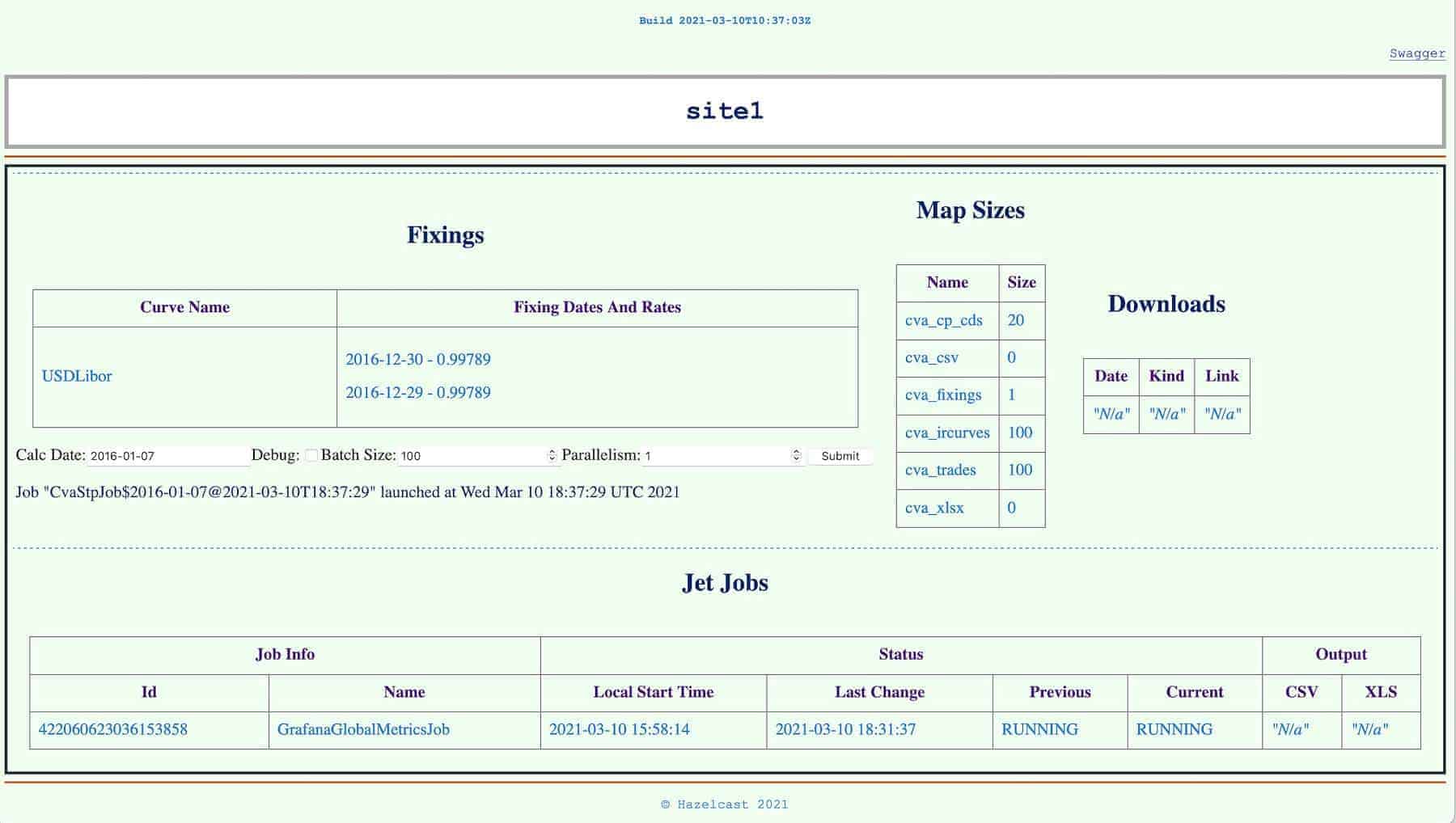

300 Container-Instanzen auf der Google-Cloud

Mit dieser Implementierung in der Cloud, so wie es bei dieser Demonstration in der Google Cloud Platform (GCP) der Fall war, können Unternehmen die Infrastruktur leicht skalieren. So lässt sich das Volumen der Berechnungen oder die erforderliche Laufzeit anpassen. Zur Demonstration dieses Cloud-nativen Ansatzes skalierte Hazelcast seine Nutzung von GCP auf einen Cache mit 300 Container-Instanzen als Teil eines Kubernetes-Clusters. Dieses bestand aus 110 virtuellen Maschinen, die auf Intel Cascade Lake-Hardware basierten. Bei einem herkömmlichen On-Premises-Ansatz müsste der Anwender eine große Anzahl von Maschinen anschaffen. Der wirtschaftliche Kompromiss zwingt zu einer Maschinenanzahl, die irgendwo zwischen Spitzenlast und geringer Last liegt und somit für keine der beiden ideal ist.aj

Sie finden diesen Artikel im Internet auf der Website:

https://itfm.link/118228

Schreiben Sie einen Kommentar