AI Act: TÜV fordert eine rasche Klärung offener Umsetzungsfragen – und bietet AI-Act-Risk-Navigator

TÜV

Der TÜV-Verband unterstützt das Inkrafttreten des europäischen AI Acts – fordert aber eine effiziente und unbürokratische Umsetzung, klare Zuständigkeiten und die Benennung von verantwortlichen Stellen – außerdem sollten dringen Umsetzungsleitfäden für die Einstufung veröffentlicht werden. Mit einem kostenlosen Online-Tool will der TÜV Klarheit verschaffen, was unter den AI Act fällt – und was nicht.

Jetzt ist der EU AI Act mit gestaffelten Übergangsfristen in Kraft getreten. Sechs Monate nach Inkrafttreten, das heißt ab Anfang 2025, sollen zunächst KI-Systeme verboten werden, die unter anderem manipulative oder täuschende Techniken einsetzen. Ab dem 1. August 2025 treten Verhaltenskodizes für bestimmte Allzweck-KI-Modelle in Kraft. Zudem müssen die EU-Mitgliedstaaten nationale Behörden für die Marktüberwachung benennen. Verpflichtende Prüfungen für Hochrisiko-KI in Bereichen wie Kreditvergabe, Personalwesen oder Strafverfolgung sind ab August 2026 erforderlich. Sie betreffen nicht nur KI-Entwickler, sondern KI-Anbieter und Betreiber risikoreicher KI. Ab 2027 treten die Anforderungen an KI in drittprüfpflichtigen Produkten in Kraft.

TÜV Verband

Der AI Act bietet die Chance, vor negativen Auswirkungen von Künstlicher Intelligenz zu schützen und gleichzeitig Innovationen zu fördern. Es ist jetzt wichtig, die Umsetzung effizient und unbürokratisch zu gestalten. Unabhängige Stellen spielen dabei eine wesentliche Rolle, nicht nur im Hinblick auf die verbindlichen Anforderungen, sondern auch im freiwilligen KI-Prüfmarkt.“

Dr. Joachim Bühler, Geschäftsführer TÜV-Verband

Herausforderungen der Umsetzung

Eine einheitliche Interpretation und konsequente Anwendung des risikobasierten Ansatzes seien entscheidend, damit der AI Act in der Praxis wirksam wird. Aus Sicht des TÜV-Verbands sollte besonderes Augenmerk auf eine effiziente und unbürokratische Umsetzung gelegt werden. Klare Zuständigkeiten und verantwortliche Stellen sind notwendig, um die Regelungen praktisch umzusetzen. So sollten Umsetzungsleitfäden für die Einstufung von Hochrisiko-KI-Systemen vom AI Office (Europäisches KI-Büro) schnellstmöglich veröffentlicht werden, um insbesondere kleinen und mittleren Unternehmen (KMU) Rechtssicherheit zu geben. Darüber hinaus sind neue KI-Risiken sowie die Entwicklung systemischer Risiken von besonders leistungsfähigen Allzweck-KI-Modellen im Blick zu behalten und der Aufbau einer systematischen KI-Schadensberichterstattung voranzutreiben.

KI-Tool: TÜV AI.Lab Risk Navigator – nicht jeder KI-Einsatz fällt unter den AI ACT

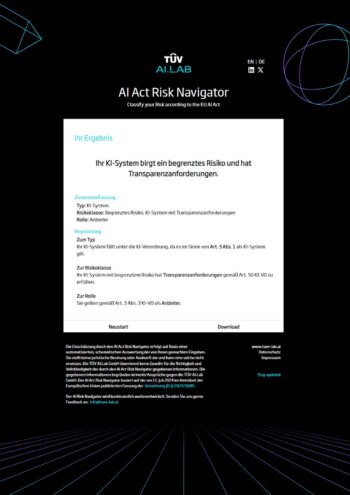

Das 2023 als Joint Venture der TÜV-Unternehmen gegründete „TÜV AI.Lab“ übersetzt regulatorische Anforderungen an KI in die Prüfpraxis und entwickelt quantifizierbare Konformitätskriterien und geeignete Prüfmethoden für KI. Zum Inkrafttreten des AI Acts veröffentlicht das TÜV AI.Lab den AI Act Risk Navigator (hier), ein kostenloses Online-Tool zur Risikoklassifizierung von KI-Systemen.

TÜV Verband

Mit dem AI Act Risk Navigator des TÜV AI.Lab bieten wir eine nutzerfreundliche Anwendung, mit der Unternehmen verstehen können, ob und wie sie vom AI Act betroffen sind. Unser Ziel ist es, Klarheit über die Auswirkungen der KI-Verordnung zu schaffen, sodass Unternehmen sich rechtzeitig vorbereiten können. Wenn wir Qualitätsanforderungen an Künstliche Intelligenz von Beginn an mitdenken, kann vertrauenswürdige Künstliche Intelligenz zum europäischen Alleinstellungsmerkmal werden.“

Franziska Weindauer, Geschäftsführerin TÜV AI.Lab

Der AI Act Risk Navigator unterstützt dabei, KI-Systeme gemäß den Risikoklassen des AI Acts einzuordnen und Transparenz über die geltenden Anforderungen zu schaffen. Die EU-Regulierung teilt KI-Anwendungen in vier Risikoklassen mit jeweils unterschiedlichen Anforderungen ein, die in den kommenden Monaten schrittweise einzuhalten sind. Systeme mit hohem Risiko, die in Bereichen wie Medizin, kritische Infrastrukturen oder Personalmanagement eingesetzt werden, unterliegen beispielsweise künftig strengen Auflagen und müssen umfassende Anforderungen an Transparenz, Sicherheit und Aufsicht erfüllen. Bei Verstößen drohen Bußgelder von bis zu 15 Millionen Euro oder bis zu drei Prozent des weltweiten Jahresumsatzes.

Der AI Act Risk Navigator ist abrufbar unter www.tuev-risk-navigator.aiaj

Sie finden diesen Artikel im Internet auf der Website:

https://itfm.link/213987

Schreiben Sie einen Kommentar