Ohne KI keine Bank 5.0: Wir brauchen DevOps, Cloud und KI, um nach vorne zu arbeiten

Avanade

Banken geben zu viel Budget für ihre Altsysteme (Stichwort: Legacy-IT) aus. Darunter leidet die Innovationsfähigkeit. Das muss sich ändern, um die Nutzung Künstlicher Intelligenz (KI), Analytik & Co. zu ermöglichen. Das Plädoyer für DevOps, Cloud und KI.

von Dr. Robert Laube, Chief Technology & Innovation Officer Avanade

Die Erhöhung von Kundenzufriedenheit, -bindung sowie -gewinnung im Sinne einer Bank 5.0 ist für die etablierten Unternehmen der Branche das A und O. Dafür muss die sogenannte Customer Experience u.a. mittels mehr Personalisierung verbessert und über alle Kanäle ausgebreitet werden. Alles andere kostet Geld, wie eine Erhebung deutlich gemacht hat.Ineffiziente Marketing-Technologien führen also messbar zu weniger Umsatz, und speziell deutsche Banken haben hier viel Nachholbedarf.

Drei Schritte müssen gemacht werden, wenn der Weg zur „Bank 5.0“ gelingen soll: die richtige technische Herangehensweise identifizieren, Daten und Informationen urbar machen sowie die passenden Methoden nutzen.”

Der Vorteil der FinTechs liegt darin, dass sie ihr Geschäft schnell und dynamisch auf der „grünen Wiese“ beginnen und schnell anpassen können. Banken mit ihren Legacy-Systemen können das nicht. Das ist der Kern des Problems. Denn mögen Bestandssysteme noch so performant laufen: Sie hemmen letztlich (zu) oft die Innovationsfähigkeit ganzer Unternehmen. Der Grund: Sie binden Budgets für die Finanzierung von Innovationen und erfüllen nicht die Anforderungen an Flexibilität, kurze Release-Zyklen etc.

Die neuen Probleme sind die alten: Zeit und Geld sind endlich

Eine weitere Studie zum Einsatz moderner Technologien im Bankensektor zeigt, …

… dass Geldhäuser etwa 19 Prozent ihres IT Budgets für die Instandhaltung ihrer Altsysteme ausgeben. Das ist deutlich zu viel in Zeiten, wo klassische IT durch Cloud & Co. mehr oder minder zur Commodity geworden ist.”

Um Trägheitssysteme wie dieses überwinden zu können, ist eine Kraft nötig; diese muss wie in der Physik umso größer sein, je größer die Masse ist. Im Idealfall speist sie sich aus Budgets – zeitlich und monetär – sowie dem Willen zur Veränderung. Das gilt nicht nur für Entscheider, sondern auch für die Belegschaft, die ihre Komfortzonen verlassen müssen.

Bei den monetären Budgets ist die bisweilen prekäre Innenfinanzierungsfähigkeit etlicher Geldhäuser durchaus eine Herausforderung – das Zinsumfeld gefährdet hier de facto auch die Fähigkeit zur Erneuerung. Gepaart mit den zu hohen Ausgaben für Bestandssysteme entsteht so ein Innovationsstau. Regulatorische Vorgaben verstärken diese Tatsache zusätzlich. Damit geht der Innovationsoffensive mit Legacy-Systemen schon am Start die Luft aus.

Dr. Robert Laube ist Leiter Cloud Infrastruktur und Anwendungsentwicklung und Chief Technology & Innovation Officer bei Avanade. Seit mehr als 20 Jahren berät er nationale und internationale Kunden im Bereich Modern Software Engineering, Analytics und Digitalisierung. Er ist Ansprechpartner zu IoT und den innovativen Möglichkeiten, die sich im Bereich Industrie 4.0 im Zusammenspiel mit Cloud bieten.

Dr. Robert Laube ist Leiter Cloud Infrastruktur und Anwendungsentwicklung und Chief Technology & Innovation Officer bei Avanade. Seit mehr als 20 Jahren berät er nationale und internationale Kunden im Bereich Modern Software Engineering, Analytics und Digitalisierung. Er ist Ansprechpartner zu IoT und den innovativen Möglichkeiten, die sich im Bereich Industrie 4.0 im Zusammenspiel mit Cloud bieten.Die Schnittstellen-Challenge

Diese Herausforderung haben FinTechs nicht. Sie besitzen in der Regel keine Banklizenz – das wollen sie auch gar nicht – sondern stellen ausschließlich Software bereit. Damit unterliegen sie eben nicht den hohen regulatorischen Anforderungen wie eine Bank. Sie sitzen allerdings häufig an der wichtigen Schnittstelle zwischen Bank und Kunde.

An dieser Stelle kommt dem Thema Schnittstellen-Management (API-Management) – nicht erst seit der Payment Service Directive 2 (PSD2) – eine große Bedeutung zu: Da nicht mehr nur die Banken auf Kontodaten zugreifen dürfen, sind die APIs wahrhaft der Schlüssel zum Erfolg. Die Bereitstellung solcher APIs vom gesicherten Backend heraus nach außen muss – natürlich – über einen gesicherten Kanal erfolgen. Entsprechende Restriktionen führen zu Einschränkungen in der IP Range, darum sind robuste Logging-Mechanismen für alle Vorgänge über den gesamten Lebenszyklus der API unumgänglich.

Ein guter Weg ist die Erstellung eines an die Bedürfnisse der Bank angepassten Entwickler-Portals; darüber können externe Partner und Entwickler die Schnittstelle(n) testen und in ihre Applikationen integrieren. Microsofts Azure API Management, Eventhubs, Stream Analytics und SQL bieten passende Umfänge aus seiner Hand.”

Cash Flow und DevOps

Entscheider müssen jedoch zuvor die Kostenbremse bei Altsystemen ziehen, um solche intelligenten Investitionen tätigen zu können. Was bei der Entwicklung bereits funktioniert, muss auch beim Betrieb Einzug halten: mehr Flexibilität durch agile Methoden. Hier ist „DevOps“ das Stichwort. Zudem gilt es, bei entsprechenden Applikationen hart zu priorisieren. Je höher Nutzen oder Einsparpotenzial, desto weiter nach oben auf der Liste. Das klingt trivial, ist erfahrungsgemäß allerdings keine Selbstverständlichkeit.

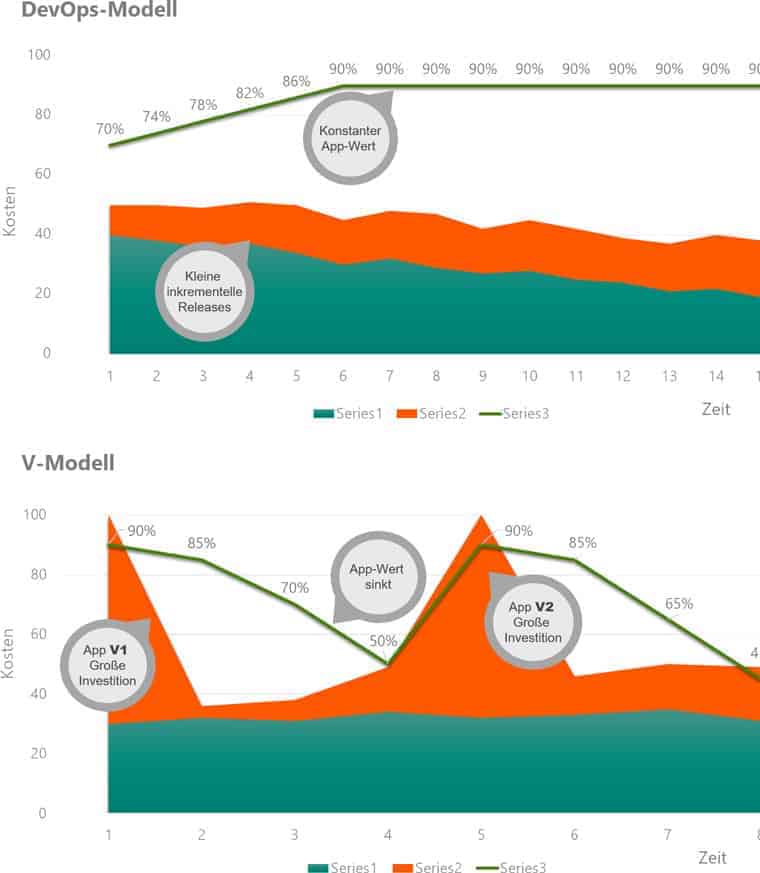

DevOps sind damit eine gute Möglichkeit, die Innenfinanzierung für IT-Innovation zu stärken, denn die Entwicklungskosten sind so über die Zeit verteilt und lassen sich aus dem Cash Flow ziehen.”

Die DevOps-Methodik erfordert die Beachtung sieben grundlegender Schritte: Teams richtig zusammensetzen, früh und intensiv testen, kontinuierlich verbessern, automatisieren, Code kontrollieren, viel experimentieren und schnelle kleine Erfolge liefern.

Gerade die Auswahl der Mitarbeiter ist dabei so wichtig, um – Stichwort Legacy-Systeme und damit – Experten! – gegebenenfalls vorhandenes Inselwissen in die neuen Projekte zu transferieren; immerhin werden bei solchen Vorhaben bisweilen ganze Applikationslandschaften im laufenden Betrieb runderneuert.”

Auch vor cross-funktionalen internationalen Mannschaften darf dabei nicht zurückgeschreckt werden. Auf die Checkliste gehören die Kultur im Team, Informationsgleichstand, einheitliche Tools und Methoden sowie konsistentes Management bis hin zu den Zielen. Gerade in Zeiten, in denen viel IT zu Commodity geworden ist, zählt der Mensch oft mehr als die Technologie – eine Lektion, die noch nicht alle gelernt haben.

Fehler? Ja bitte!

Ein Proof of Concept rückt dabei zunehmend in den Hintergrund, denn Geschwindigkeit zählt. Das sogenannte MVP (Minimum Viable Product) ist das Konzept der Stunde, auch wenn es tradierten deutschen Perfektionismus-Tugenden widerspricht. In komplexen IT-Projekten benötigen Abstimmungsprozesse jedoch schlicht zu viel Zeit und Energie. Demnach ist auch das Wasserfall-Konzept mit V-Modell überholt. Stattdessen gilt es, über mehrere Sprints Ergebnisse zu erzielen. Diese bestehen aus Leistungs- und Lasttests, dem Überprüfen der Nutzerakzeptanz sowie Ausdauer- und Penetrationstests. In die Köpfe muss dabei das Mantra: Früh testen, oft testen.

Avanade

Anfängliches „Scheitern“ ist hier ebenso Methode wie zügiges Verbessern

Unter dem Strich steht letztlich ein schnellerer Go-Live. Doch dieses „schnell kleine Erfolge liefern“-Prinzip ist leider noch nicht überall angekommen. Und ein Erfolg in diesem Sinne hier ist ein Erfolg mit einem Go-Live gegenüber Usern – nicht der Start einer Studie! Vielfach wird geplant und geplant, budgetiert und budgetiert… und die Zeit vergeht. Es sind hier jedoch Macher gefragt, keine Theoretiker. Dabei dürfen erste negative Erfahrungswerte nicht über die in Summe zu erreichenden Vorteile hinwegtäuschen:

Ein V-Modell-Projekt funktioniert zu Beginn immer besser, aber die Inbetriebnahme erfolgt später, und im Zeitverlauf erreicht ein DevOps-gesteuertes Projekt stets einen höheren Reifegrad. Kosten sind beim DevOps-Konzept zudem gleichmäßiger verteilt, wie oben erwähnt.”

Automatisierung verringert die Bedeutung des „menschlichen Faktors“. Hierbei ist es nicht die Idee, Personalkosten zu reduzieren; vielmehr sollen vorhandene Ressourcen effizient allokiert werden. Hier wie bei der Code-Kontrolle lassen sich vorhandene Cloud-basierte KI-Lösungen gut und schnell einbinden. Dieses Pay per Use ist ein weiterer Baustein auf dem Weg, schnell aufeinanderfolgend verschiedene Dinge versuchen zu können.

Fazit: Legacy ersetzen, DevOps einführen

Wie sehr die alte Liebe zu Legacy-Systemen nicht rostet, zeigt die erschreckende Zahl einer weiteren Studie: Für 98 Prozent aller deutschen Entscheider ist KI Zeitgeist-Phänomen. Aus meiner Sicht ein fataler Fehler. Und nur 15 Prozent glauben, dass die Customer Experience von KI profitieren kann; magere 18 Prozent sehen Vorteile bei digitalen Assistenten. Gleichzeitig, und das sei hier wiederholt, fließt annähernd ein Fünftel der Budgets in Wartung.

Der Weg zur Bank 5.0 sieht anders aus – er ist mit altem Gerät und altem Denken nicht zu schaffen.”Dr. Robert Laube

Sie finden diesen Artikel im Internet auf der Website:

https://itfm.link/77420

Schreiben Sie einen Kommentar